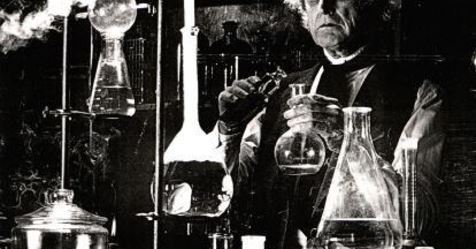

Il professor Josiah Willard Gibbs era un frutto un poco atipico dei suoi tempi, ingegnere, chimico, fisico, matematico ma sopratutto teorico. Nel secolo successivo lo si sarebbe definito un chimico fisico. anche se forse l'etichetta non gli sarebbe piaciuta.

Fattostà che il professor Gibbs nel 1882 pubblicò un articolone su una rivista piuttosto oscura (a bassissimo impact factor, si direbbe oggi), "Transactions of the Connecticut Academy of Arts and Sciences". E siccome era un'articolone di 300 pagine e spiccioli fu pubblicato a puntate nell'arco di 3 (!) anni.

L'articolone si intitolava "On the Equilibrium of Heterogeneous Substances", e dopo la chimica non fu più la stessa, senza esagerare.

L'energia definita da Gibbs (universalmente nota come energia libera di Gibbs) finì per ricollegare la termodinamica dei fisici a tutto ciò che era stato definito da un secolo di chimica, dalle leggi dei gas all'azione di massa fino all'equilibrio, definendo la termodinamica chimica (largamente sovrapponibile a quel che si intende oggi per chimica fisica ) come un dominio specifico, per quante basi condividesse con la fisica.

L'energia libera di Gibbs, G, uguale a H-TS (dove H è l'entalpia - il calore - T la temperatura in gradi Kelvin e S l'entropia) ci dice quali trasfomazioni chimiche e chimico fisiche possono avvenire in determinate condizioni, ovvero solo quelle che portano a valori di G più bassi.

ΔG=0, per un sistema in condizioni di equilibrio (chimico), e la costante di equilibrio (il rapporto tra prodotto delle concentrazioni dei prodotti di reazione e quello dei reagenti) è funzione della differenza tra G dei prodotti e G dei reagenti. Tramite la costante di equilibrio G è collegata alle costanti cinetiche, ed essendo espressione di potenziale chimico è direttamente correlata al potenziale elettrochimico (e quindi ricavabile dalla misura del potenziale elettrico all'elettrodo di una cella elettrochimica).

A differenza dell'entropia, l'energia libera di Gibbs non è entrata nella cultura pop. Troppo poco semplificabile, troppo poco legata a concetti comuni e facilmente identificabili.

Ma, ricollegandoci al post di ieri (http://ilchimicoscettico.blogspot.com/2018/07/entropia-uova-impasti-e-maionese.html) è quella che governa i processi, le trasformazioni. Facciamo un esempio terra terra. Prendiamo una soluzione satura di sale da cucina a 100°C e facciamola raffreddare. Lentamente si formeranno cristalli di cloruro sodio. Raffreddando il sistema passa da una situazione ad alto disordine (acqua salata) ad una a disordine più basso (acqua salata + sale, con parziale separazione dei componenti). Ma si tratta del minimo dell'energia libera di Gibbs per quel sistema a quella temperatura. Ed è quello che conta.

(P.S.: ovviamente non si tratta di un sistema isolato, il flusso di calore verso l'esterno c'è, ma è meno banale di quel che può apparire, perché al raffreddamento del sistema si sovrappongono la nucleazione - endotermica, ovvero che assorbe calore - e la crescita dei cristalli che invece è esotermica ovvero rilascia calore, nel caso di NaCl).

https://en.wikipedia.org/wiki/Josiah_Willard_Gibbs

martedì 31 luglio 2018

ENTROPIA, UOVA, IMPASTI (E MAIONESE)

Sabine Hossenfelder dice la sua su come "raccontare" l'entropia:

Sabine Hossenfelder dice la sua su come "raccontare" l'entropia:"Davvero l'idea che l'entropia misuri il disordine non è per niente d'aiuto. Supponiamo che io prepari un impasto, che io rompa un uovo e lo faccia cadere sulla farina. Aggiungo zucchero e burro e mescolo finché l'impasto non è omogeneo. Quale stato è più ordinato, l'uovo rotto sulla farina con sopra il burro o l'impasto finale? Direi l'impasto. Ma quello è lo stato a più alta entropia....

L'entropia è definita come il numero di microstati che danno lo stesso macrostato. I microstati contengono tutti i dettagli dei componenti individuali di un sistema. Il macrostato invece è caratterizzato solo da informazioni generali, come "separato in due strati" o "mediamente omogeneo". Ci sono molti stati per gli ingredienti dell'impasto che daranno l'impasto quando mescolati, ma assai pochi stati che separeranno uova e farina quando mescolate. Quindi l'impasto è a più alta entropia..."

Questa definizione di entropia è mutuata dalla termodinamica statistica, uno strumento potente i cui risultati convergono su quelli della termodinamica classica. Si tratta di modelli, e ognuno dei due è più utile e maneggevole dell'altro, a seconda della situazione.

La prima cosa che faccio notare è che quando si parla di entropia come misura del disordine la definizione muta a seconda del concetto di disordine che possediamo. Agli occhi di un chimico è immediato che l'impasto sia lo stato a più alta entropia.

La seconda cosa che faccio notare è che lo stato a più alta entropia è in questo caso il risultato di un processo non spontaneo. Parafrasando Hossenfelder, sono pochissimi gli stati che portano spontaneamente a impasto da uovo rotto più farina (pochissimi vuol dire di fatto 0, ma stiamo parlando di termodinamica statistica, e quindi il concetto di "stato impossibile" va maneggiato con cautela, mentre è più comune quello di "stato improbabile").

Comunque il risultato del processo di mescolamento è l'impasto e il processo, in questo caso, è irreversibile.

Ma facciamo un altro esempio: uova e olio. In questo caso il prodotto a più alta entropia è la maionese. Ma la probabilità di ottenimento della maionese alla fine del processo non è particolarmente alta, e di sicuro non è alta quanto quella dell'impasto. La maionese può "impazzire", ovvero dare un sistema a due fasi parzialmente mischiate, a entropia più bassa rispetto alla maionese.

E quindi è il percorso, il processo, il fenomeno che diventa cruciale: l'entropia finale non guida la trasformazione (non costituisce la "driving force" del processo) - cosa è che gioca nell'ottimento della maionese (che è una particolare emulsione)? Una quantità di fattori, sforzo di taglio dell'agitazione, forza ionica delle fasi acquose (l'uovo), carica elettrostatica.

https://backreaction.blogspot.com/2018/07/10-physics-facts-you-should-have.html?m=1

venerdì 27 luglio 2018

SILDENAFIL CONTRO LA RESTRIZIONE DELLA CRESCITA INTRAUTERINA, 11 NEONATI MORTI E SPERIMENTAZIONE BLOCCATA

Molta indignazione sulla sperimentazione del viagra nelle donne in gravidanza, conclusa dal comitato di controllo dopo 11 bambini morti.

In molti l'hanno vista come una sciagurata sperimentazione finalizzata al business. Ma il business non c'entra, Pfizer non c'entra, è stato usato il generico e si è trattato di una delle miriadi di sperimentazioni off-label di un farmaco (come quelle alla base della querelle su equivalenza tra Avastin e Lucentis, per fare un esempio).

Ovvero un medico può far uso di un medicinale per indicazioni diverse da quelle per cui è stato immesso in commercio. Sotto la sua responsabilità.

E il sildenafil citrato, universalmente noto col nome del farmaco branded, Viagra, è stato approvato anni e anni fa. Quindi poteva essere legittimamente usato off-label.

Piccolo particolare, una donna in gravidanza fa storia a sé, per uso (e sperimentazione) di farmaci. Basta ricordarsi del talidomide: utile contro i mielomi, fu la causa delle nascite di bimbi focomelici.

Ma vediamo meglio di che si tratta.

Da un po' si pubblica sul possibile uso di sildenafil contro la restrizione della crescita intrauterina (cioè contro l'insufficiente sviluppo fetale). Non precisamente cutting edge science, nella maggioranza dei casi.

Una review australiana evidenziava rischi non significativi dal lato materno, ma parlava di dati insufficienti (https://www.ncbi.nlm.nih.gov/pubmed/27926905).

La cosa rifletteva quanto riportato da FDA per quel che riguarda uso e effetti collaterali:

US FDA pregnancy category B: Animal reproduction studies have failed to demonstrate a risk to the fetus and there are no adequate and well-controlled studies in pregnant women.

Su cosa si basava l'avvio della sperimentazione olandese di sildenafil? Non su un'ulteriore modello animale preclinico (probabilmente un regolatore avrebbe voluto vedere qualcosa su scimmie, vista la delicatezza della materia), ma su una metaanalisi della letteratura preclinica disponibile, all'incirca quella che gli australiani definivano "dati insufficienti": "Sildenafil During Pregnancy: A Preclinical Meta-Analysis on Fetal Growth and Maternal Blood Pressure" (https://www.ncbi.nlm.nih.gov/pubmed/28893896).

Gli studi esaminati erano su topo, ratto, cavia, coniglio, pecora. Più due studi sull'uomo su piccoli numeri. Piccoli. La metaanalisi del gruppo olandese così concludeva:

"By including all preclinical and clinical studies, our analysis

contained a large variation in study design. We show that in

the presence of placental insufficiency (FGR/preeclampsia),

sildenafil can increase fetal growth by ≈10%. Because we

observe that optimal fetal growth might be reached at a daily

dose about an order of magnitude higher than the dose currently used, we recommend human dose-finding studies for

optimal fetal growth. This should go hand in hand with obtaining additional safety data in human pregnancy, especially on

plasma volume expansion during pregnancy and on long-term

fetal effects. Continuous exposure to PDE5 inhibition by

administration of sildenafil or long-acting PDE5 inhibitors

seems promising."

In breve, i dati che sembravano pochi agli australiani (e a FDA) sono sembrati promettenti agli olandesi. Ed è su questa base - decisamente scarsa - che è stato programmato uno studio con l'arruolamento di 350 pazienti tra il 2015 e il 2020, donne in gravidanza con insufficienza placentare e prognosi critica per il nascituro. Un long shot che evidentemente non sembrava tale né a chi ha proposto, né a chi ha approvato.

350 è un numero da fase II di quelle corpose - o da segmento di fase III. Uno studio ad interim quest'anno ha rilevato che su 98 pazienti trattate 11 neonati erano morti di ipertensione polmonare, e lo studio è stato sospeso. Nel gruppo di controllo, non trattato col farmaco, la mortalità dei neonati è stata all'incirca paragonabile.

Prima considerazione: il sildenafil si è dimostrato efficace nel breve termine per adulti *affetti* da ipertensione polmonare. Nel ramo farmaceutico si sa e si sa bene (tanto che di solito non ci si mette la mano): la fisiologia del soggetto in età pediatrica è molto diversa da quella del soggetto adulto. E infatti EMA lamenta l'assenza di programmi di sviluppo farmaceutico destinati alla pediatria. Senza ottenere troppa risposta. Eccessivamente rischiosi.

Seconda considerazione: le sperimentazioni off label sono sperimentazioni a tutti gli effetti, come quelle che le farmaceutiche fanno per nuove indicazioni di farmaci già esistenti. Ma mentre la sperimentazione industriale è sottoposta ad un'agenzia regolatoria, quella per l'uso off label non lo è.

Terza considerazione: il comitato etico (o come si chiama in Olanda) ha autorizzato lo studio evidentemente sulla base della metaanalisi preclinica degli autori. Metaanalisi basata su studi che altri avevano giudicato carenti dal punto di vista della significatività dei dati.

L'indignazione è giustificata? A prima vista sì. Ma questa osservazione di Ganzevoort De Volkskrant mi ha dato da pensare:

“Se ne parlava alle conferenze. Colleghi stranieri lasciavano intendere che lo avevano prescritto con buoni risultati. Nel mio ambulatorio donne in attesa mi hanno chiesto di prescriverglielo. Cosa sarebbe successo se lo avessero acquistato on line? Non lo so. Chi può saperlo?"

Tutto ciò dà una sgradevole impressione sulla "scientificità" della ricerca clinica ostetrico-ginecologica, perlomeno quando si parla di farmaci. E sottolinea come le sperimentazioni off-label presentino criticità del tutto affini alle sperimentazioni dell'industria, ma siano soggette a vincoli e controlli esigui.

https://www.theguardian.com/world/2018/jul/24/eleven-babies-die-dutch-women-viagra-drug-trial

In molti l'hanno vista come una sciagurata sperimentazione finalizzata al business. Ma il business non c'entra, Pfizer non c'entra, è stato usato il generico e si è trattato di una delle miriadi di sperimentazioni off-label di un farmaco (come quelle alla base della querelle su equivalenza tra Avastin e Lucentis, per fare un esempio).

Ovvero un medico può far uso di un medicinale per indicazioni diverse da quelle per cui è stato immesso in commercio. Sotto la sua responsabilità.

E il sildenafil citrato, universalmente noto col nome del farmaco branded, Viagra, è stato approvato anni e anni fa. Quindi poteva essere legittimamente usato off-label.

Piccolo particolare, una donna in gravidanza fa storia a sé, per uso (e sperimentazione) di farmaci. Basta ricordarsi del talidomide: utile contro i mielomi, fu la causa delle nascite di bimbi focomelici.

Ma vediamo meglio di che si tratta.

Da un po' si pubblica sul possibile uso di sildenafil contro la restrizione della crescita intrauterina (cioè contro l'insufficiente sviluppo fetale). Non precisamente cutting edge science, nella maggioranza dei casi.

Una review australiana evidenziava rischi non significativi dal lato materno, ma parlava di dati insufficienti (https://www.ncbi.nlm.nih.gov/pubmed/27926905).

La cosa rifletteva quanto riportato da FDA per quel che riguarda uso e effetti collaterali:

US FDA pregnancy category B: Animal reproduction studies have failed to demonstrate a risk to the fetus and there are no adequate and well-controlled studies in pregnant women.

Su cosa si basava l'avvio della sperimentazione olandese di sildenafil? Non su un'ulteriore modello animale preclinico (probabilmente un regolatore avrebbe voluto vedere qualcosa su scimmie, vista la delicatezza della materia), ma su una metaanalisi della letteratura preclinica disponibile, all'incirca quella che gli australiani definivano "dati insufficienti": "Sildenafil During Pregnancy: A Preclinical Meta-Analysis on Fetal Growth and Maternal Blood Pressure" (https://www.ncbi.nlm.nih.gov/pubmed/28893896).

Gli studi esaminati erano su topo, ratto, cavia, coniglio, pecora. Più due studi sull'uomo su piccoli numeri. Piccoli. La metaanalisi del gruppo olandese così concludeva:

"By including all preclinical and clinical studies, our analysis

contained a large variation in study design. We show that in

the presence of placental insufficiency (FGR/preeclampsia),

sildenafil can increase fetal growth by ≈10%. Because we

observe that optimal fetal growth might be reached at a daily

dose about an order of magnitude higher than the dose currently used, we recommend human dose-finding studies for

optimal fetal growth. This should go hand in hand with obtaining additional safety data in human pregnancy, especially on

plasma volume expansion during pregnancy and on long-term

fetal effects. Continuous exposure to PDE5 inhibition by

administration of sildenafil or long-acting PDE5 inhibitors

seems promising."

In breve, i dati che sembravano pochi agli australiani (e a FDA) sono sembrati promettenti agli olandesi. Ed è su questa base - decisamente scarsa - che è stato programmato uno studio con l'arruolamento di 350 pazienti tra il 2015 e il 2020, donne in gravidanza con insufficienza placentare e prognosi critica per il nascituro. Un long shot che evidentemente non sembrava tale né a chi ha proposto, né a chi ha approvato.

350 è un numero da fase II di quelle corpose - o da segmento di fase III. Uno studio ad interim quest'anno ha rilevato che su 98 pazienti trattate 11 neonati erano morti di ipertensione polmonare, e lo studio è stato sospeso. Nel gruppo di controllo, non trattato col farmaco, la mortalità dei neonati è stata all'incirca paragonabile.

Prima considerazione: il sildenafil si è dimostrato efficace nel breve termine per adulti *affetti* da ipertensione polmonare. Nel ramo farmaceutico si sa e si sa bene (tanto che di solito non ci si mette la mano): la fisiologia del soggetto in età pediatrica è molto diversa da quella del soggetto adulto. E infatti EMA lamenta l'assenza di programmi di sviluppo farmaceutico destinati alla pediatria. Senza ottenere troppa risposta. Eccessivamente rischiosi.

Seconda considerazione: le sperimentazioni off label sono sperimentazioni a tutti gli effetti, come quelle che le farmaceutiche fanno per nuove indicazioni di farmaci già esistenti. Ma mentre la sperimentazione industriale è sottoposta ad un'agenzia regolatoria, quella per l'uso off label non lo è.

Terza considerazione: il comitato etico (o come si chiama in Olanda) ha autorizzato lo studio evidentemente sulla base della metaanalisi preclinica degli autori. Metaanalisi basata su studi che altri avevano giudicato carenti dal punto di vista della significatività dei dati.

L'indignazione è giustificata? A prima vista sì. Ma questa osservazione di Ganzevoort De Volkskrant mi ha dato da pensare:

“Se ne parlava alle conferenze. Colleghi stranieri lasciavano intendere che lo avevano prescritto con buoni risultati. Nel mio ambulatorio donne in attesa mi hanno chiesto di prescriverglielo. Cosa sarebbe successo se lo avessero acquistato on line? Non lo so. Chi può saperlo?"

Tutto ciò dà una sgradevole impressione sulla "scientificità" della ricerca clinica ostetrico-ginecologica, perlomeno quando si parla di farmaci. E sottolinea come le sperimentazioni off-label presentino criticità del tutto affini alle sperimentazioni dell'industria, ma siano soggette a vincoli e controlli esigui.

https://www.theguardian.com/world/2018/jul/24/eleven-babies-die-dutch-women-viagra-drug-trial

mercoledì 25 luglio 2018

LA GLOBALIZZAZIONE DELLA CHIMICA FARMACEUTICA (E LA DESERTIFICAZIONE DELL'INDUSTRIA EUROPEA)

"Sergio Marchionne ha individuato le cause della sovraccapacità produttiva dell’industria europea nella resistenza alla eliminazione, durante le crisi precedenti, di imprese e impianti ridondanti" (J. Ewing and B. Vlasic, Europe’s auto industry has reached day of reckoning, “The New York Times”, July 25 2012) (http://www.economiaepolitica.it/politiche-economiche/europa-e-mondo/industria-italiana-qual-e-la-causa-della-declino/).

Magari per l'industria automobilistica sarà stato anche vero, ma credo di aver cominciato a leggere su riviste del settore di sovracapacità di produzione GMP in occidente tipo 15 anni fa. Notare "in occidente".

Non è che in 15 anni il consumo di farmaci in occidente sia diminuito. A domanda crescente o costante cos'è che determinava la sovracapacità occidentale di produzione di principi attivi farmaceutici? Lo spostamento verso fornitori indiani e cinesi.

Il fenomeno nella sua natura non era nuovo: sin dagli anni 80 si erano viste produzioni sparire per migrare verso nazioni a più basso costo: la fortuna di Pliva, farmaceutica croata è iniziata così.

E non è che i produttori cinesi non avessero presenza globale, negli anni 90. Ma non esportavano principi attivi, esportavano intermedi che con gli anni diventavano sempre più avanzati.

Ci sono regole abbastanza precise che stabiliscono fino a che punto la sintesi chimica di un principio attivo farmaceutico possa essere condotta al di fuori delle Good Manufacturing Practices (e quindi da stabilimenti certificati ed ispezionati): la regola generale dice che si può stare fuori GMP fino all'ultima formazione di legame carbonio-carbonio. Poi ci sono casi particolari che riguardano catene laterali di antibiotici e antitumorali (tassani) e via dicendo.

Quindi all'inizio del nuovo millennio molti produttori di API generici in Europa (e altrove, immagino) praticavano quella che alcuni avevano ribattezzato "la chimica dell'ultimo passaggio".

La cosa si manteneva in quanto previsto dai regolatori e le fasi cruciali della produzione erano sotto l'ombrello (per i pazienti) delle agenzie occidentali.

Poi arrivò la la direttiva 2004/27/CE. I produttori asiatici potevano esportare in Europa di fatto autocertificando la compliance alle linee guida GMP.

Praticamente una mossa deflazionista in stile ultimi anni della corona francese prima della Rivoluzione. Solo che in questo caso non si tassavano i propri produttori per sostituire il loro prodotto con il prodotto importato. Si lasciava invece in essere il carico regolatorio (sacrosanto) a cui erano sottoposti, che veniva risparmiato alla concorrenza asiatica. Invertendo l'ordine dei fattori il prodotto non cambia.

Nel tentare di resistere al colpo e di continuare a sopravvivere nonostante il pesante handicap imposto dalla politica (europea) è successo un po' di tutto. Ma alla fine siamo arrivati all'80% della produzione chimica (e chimico-farmaceutica) mondiale accentrata in Cina. Un paese che, come il Giappone, si finanzia con la moneta immessa in circolazione dalla propria banca centrale, oltre che con il surplus delle partite correnti (che gli ha permesso di accumulare enormi riserve in dollari, per esempio).

Quindi la "sovracapacità produttiva occidentale" era una colossale truffa, propalata al fine di facilitare un processo i cui primi beneficiari sono stati il capitale (prevalentemente finanziario) occidentale (il taglio dei costi è profitto) e le politiche di contenimento della spesa farmaceutica pubblica dei paesi europei. Perché il fabbisogno, come volumi, non si è contratto. Semplicemente non è più soddisfatto da produttori europei.

E quindi scusate se vedo nel manager italo canadese solo un altro dei propugnatori di questo genere di politiche industriali guidate anche da un sistema di cambi fissi (dove spostare una produzione al di fuori dell'area monetaria è una mossa vincente già solo per motivi di cambio valutario).

Ah, per quel che riguarda la chimica farmaceutica non si tratta di una mia personale e parziale visione del fenomeno. E' un fatto noto a tutti, nel ramo:

"The pharmaceutical small molecule API manufacturing industry is now experiencing a period of rapid change. This change is being driven by factors such as the changing nature of the drugs being made, expiry of patents covering the top-selling pharmaceuticals, the growth of the API manufacturing industry in India, China and Asia, shrinking margins causing downward pressure on pricing and THE DRIVE BY GOVERNMENTS TO CUT SPENDING ON DRUGS."

http://www.pharmaventures.com/consult/white/2

Magari per l'industria automobilistica sarà stato anche vero, ma credo di aver cominciato a leggere su riviste del settore di sovracapacità di produzione GMP in occidente tipo 15 anni fa. Notare "in occidente".

Non è che in 15 anni il consumo di farmaci in occidente sia diminuito. A domanda crescente o costante cos'è che determinava la sovracapacità occidentale di produzione di principi attivi farmaceutici? Lo spostamento verso fornitori indiani e cinesi.

Il fenomeno nella sua natura non era nuovo: sin dagli anni 80 si erano viste produzioni sparire per migrare verso nazioni a più basso costo: la fortuna di Pliva, farmaceutica croata è iniziata così.

E non è che i produttori cinesi non avessero presenza globale, negli anni 90. Ma non esportavano principi attivi, esportavano intermedi che con gli anni diventavano sempre più avanzati.

Ci sono regole abbastanza precise che stabiliscono fino a che punto la sintesi chimica di un principio attivo farmaceutico possa essere condotta al di fuori delle Good Manufacturing Practices (e quindi da stabilimenti certificati ed ispezionati): la regola generale dice che si può stare fuori GMP fino all'ultima formazione di legame carbonio-carbonio. Poi ci sono casi particolari che riguardano catene laterali di antibiotici e antitumorali (tassani) e via dicendo.

Quindi all'inizio del nuovo millennio molti produttori di API generici in Europa (e altrove, immagino) praticavano quella che alcuni avevano ribattezzato "la chimica dell'ultimo passaggio".

La cosa si manteneva in quanto previsto dai regolatori e le fasi cruciali della produzione erano sotto l'ombrello (per i pazienti) delle agenzie occidentali.

Poi arrivò la la direttiva 2004/27/CE. I produttori asiatici potevano esportare in Europa di fatto autocertificando la compliance alle linee guida GMP.

Praticamente una mossa deflazionista in stile ultimi anni della corona francese prima della Rivoluzione. Solo che in questo caso non si tassavano i propri produttori per sostituire il loro prodotto con il prodotto importato. Si lasciava invece in essere il carico regolatorio (sacrosanto) a cui erano sottoposti, che veniva risparmiato alla concorrenza asiatica. Invertendo l'ordine dei fattori il prodotto non cambia.

Nel tentare di resistere al colpo e di continuare a sopravvivere nonostante il pesante handicap imposto dalla politica (europea) è successo un po' di tutto. Ma alla fine siamo arrivati all'80% della produzione chimica (e chimico-farmaceutica) mondiale accentrata in Cina. Un paese che, come il Giappone, si finanzia con la moneta immessa in circolazione dalla propria banca centrale, oltre che con il surplus delle partite correnti (che gli ha permesso di accumulare enormi riserve in dollari, per esempio).

Quindi la "sovracapacità produttiva occidentale" era una colossale truffa, propalata al fine di facilitare un processo i cui primi beneficiari sono stati il capitale (prevalentemente finanziario) occidentale (il taglio dei costi è profitto) e le politiche di contenimento della spesa farmaceutica pubblica dei paesi europei. Perché il fabbisogno, come volumi, non si è contratto. Semplicemente non è più soddisfatto da produttori europei.

E quindi scusate se vedo nel manager italo canadese solo un altro dei propugnatori di questo genere di politiche industriali guidate anche da un sistema di cambi fissi (dove spostare una produzione al di fuori dell'area monetaria è una mossa vincente già solo per motivi di cambio valutario).

Ah, per quel che riguarda la chimica farmaceutica non si tratta di una mia personale e parziale visione del fenomeno. E' un fatto noto a tutti, nel ramo:

"The pharmaceutical small molecule API manufacturing industry is now experiencing a period of rapid change. This change is being driven by factors such as the changing nature of the drugs being made, expiry of patents covering the top-selling pharmaceuticals, the growth of the API manufacturing industry in India, China and Asia, shrinking margins causing downward pressure on pricing and THE DRIVE BY GOVERNMENTS TO CUT SPENDING ON DRUGS."

http://www.pharmaventures.com/consult/white/2

LA DURA VITA DELLA RICERCA FARMACEUTICA PRIVATA

Ve lo ricordate il portfolio manager di Novartis che profetizzò il rendimento zero per gli investimenti in ricerca farmaceutica entro cinque anni?

Ve lo ricordate l'analista di Goldman Sachs che sosteneva che il business model di Gilead è perdente, perché sviluppare farmaci che GUARISCONO non è economicamente sostenibile?

Vi ricordate quelli che discutono di delinking (scoperto dalla ricerca pubblica, prodotto in Cina - sviluppato non si capisce bene da chi) per abbattere i costi dei farmaci?

L'industria che sviluppa nuovi farmaci non è ben vista (quella che sviluppa o produce vaccini sì). Sarebbe ben vista se tutto il processo di ricerca, sviluppo, immissione in commercio costasse quel che costa un genericista cinese. Ma così non è. E allo stato delle cose (sottolineato) la pressione al ribasso sui prezzi dei farmaci frutto di innovazione significa pressione al ribasso sui livelli occupazionali. Ecco un esempio recente di quanto sia "facile" la vita delle aziende research based.

Fingolimod (Novartis) è stato approvato da FDA nel 2010 per la sclerosi multipla.

Come l'Eribulina (Eisai) è uno degli ultimi frutti della ricerca sui composti naturali.

Fingolimod nasce dal lavoro sulla miriocina.

La miriocina venne isolata per la prima volta nel 1992 da Isaria sinclairii, un fungo che parassita le ninfe delle cicale, usato come tonico nella medicina tradizionale tibetana e in quella cinese. La miriocina è un antibiotico ma sopratutto un'analogo naturale della sfingosina, importante elemento costitutivo della membrana cellulare tramite i fosfolipidi suoi derivati, come la sfingomielina.

Dal Merck Index leggo che Fingolimod è "un immunomodulatore che evoca una redistribuzione reversibile dei linfociti dalla circolazione al tessuto linfatico secondario". E' la proprietà che previene le ricadute nella sclerosi multipla. In più inibisce l'attività delle cellule T citotossiche CD8. Il che provoca vulnerabilità ai virus, ma anche limita gli effetti della sclerosi multipla.

Nel 2010 FDA approva a Novartis Fingolimod. La prima *pillola* per il trattamento della sclerosi multipla - non guarisce, ma evita le ricadute e rallenta la progressione. Non priva di problemi, all'inizio della terapia i pazienti vanno controllati per segnali di insorgenza di edema maculare o problemi cardiaci. E poi c'è la questione dell'accresciuta vulnerabilità alle infezioni virali.

Però è uno strumento importante in grado di migliorare la vita di pazienti con poche opzioni.

Gilenya è il nome commerciale di Fingolimod e sarebbe stato protetto dai brevetti fino al 2027. Ma i genericisti hanno sfidato alcuni brevetti Novartis e hanno vinto. Novartis sta ricorrendo, e se perde ci sarà Fingolimod generico a partire dal 2019, il che vorrebbe dire, per chi lo ha sviluppato, 9 anni di vita in esclusività del prodotto. Un po' poco.

Ve lo ricordate l'analista di Goldman Sachs che sosteneva che il business model di Gilead è perdente, perché sviluppare farmaci che GUARISCONO non è economicamente sostenibile?

Vi ricordate quelli che discutono di delinking (scoperto dalla ricerca pubblica, prodotto in Cina - sviluppato non si capisce bene da chi) per abbattere i costi dei farmaci?

L'industria che sviluppa nuovi farmaci non è ben vista (quella che sviluppa o produce vaccini sì). Sarebbe ben vista se tutto il processo di ricerca, sviluppo, immissione in commercio costasse quel che costa un genericista cinese. Ma così non è. E allo stato delle cose (sottolineato) la pressione al ribasso sui prezzi dei farmaci frutto di innovazione significa pressione al ribasso sui livelli occupazionali. Ecco un esempio recente di quanto sia "facile" la vita delle aziende research based.

Fingolimod (Novartis) è stato approvato da FDA nel 2010 per la sclerosi multipla.

Come l'Eribulina (Eisai) è uno degli ultimi frutti della ricerca sui composti naturali.

Fingolimod nasce dal lavoro sulla miriocina.

La miriocina venne isolata per la prima volta nel 1992 da Isaria sinclairii, un fungo che parassita le ninfe delle cicale, usato come tonico nella medicina tradizionale tibetana e in quella cinese. La miriocina è un antibiotico ma sopratutto un'analogo naturale della sfingosina, importante elemento costitutivo della membrana cellulare tramite i fosfolipidi suoi derivati, come la sfingomielina.

Dal Merck Index leggo che Fingolimod è "un immunomodulatore che evoca una redistribuzione reversibile dei linfociti dalla circolazione al tessuto linfatico secondario". E' la proprietà che previene le ricadute nella sclerosi multipla. In più inibisce l'attività delle cellule T citotossiche CD8. Il che provoca vulnerabilità ai virus, ma anche limita gli effetti della sclerosi multipla.

Nel 2010 FDA approva a Novartis Fingolimod. La prima *pillola* per il trattamento della sclerosi multipla - non guarisce, ma evita le ricadute e rallenta la progressione. Non priva di problemi, all'inizio della terapia i pazienti vanno controllati per segnali di insorgenza di edema maculare o problemi cardiaci. E poi c'è la questione dell'accresciuta vulnerabilità alle infezioni virali.

Però è uno strumento importante in grado di migliorare la vita di pazienti con poche opzioni.

Gilenya è il nome commerciale di Fingolimod e sarebbe stato protetto dai brevetti fino al 2027. Ma i genericisti hanno sfidato alcuni brevetti Novartis e hanno vinto. Novartis sta ricorrendo, e se perde ci sarà Fingolimod generico a partire dal 2019, il che vorrebbe dire, per chi lo ha sviluppato, 9 anni di vita in esclusività del prodotto. Un po' poco.

martedì 24 luglio 2018

3+2 E CONSEGUENZE INATTESE

Al centro del vortice mi ricordo, come sempre, le metriche stupide. Negli anni novanta era periodico l'allarme sui media riguardo lo scarso numero di laureati in Italia. L'origine dell'allarme, come spesso accade, erano studi OCSE.

Andando indietro nel tempo di un cinque-dieci anni invece mi ricordo che avevamo un problema di allineamento delle qualifiche. La nostra vecchia laurea era più di un master anglosassone, da un punto di vista del contenuto formativo, e meno di un PhD. Veniva allineata ai master, al ribasso, e i nostri dottorati venivano allineati ai PhD (pure se, secondo molti, erano qualcosa di più). All'incirca in quel periodo cominciai a udire i germi di quel paradigma che avrebbe portato alla situazione attuale. Un rettore in un'intervista ad un quotidiano ebbe a dichiarare che una buona università si fa con buoni studenti. Cosa che a me pareva aberrante (da studente): mi pareva scontato che una buona università si facesse con una buona didattica.

Il modello dei tempi, quello dell'ordinamento antico, non prevedeva numero chiuso. Nessuna barriera all'ingresso e selezione basata sugli esami: quindi alto numero di abbandoni e di fuori corso.

Al primo anno dove avevo iniziato il mio percorso universitario eravamo una quarantina di matricole. All'inizio del secondo anno eravamo una ventina. A seguire i corsi del quinto anno eravamo in dieci.

Venticinque anni dopo, tornando brevemente nel luogo di origine, la situazione era cambiata. L'infame combinato disposto di riforma Gelmini e 3+2 aveva provocato conseguenze per me inimmaginabili. Come mi spiegò un vecchio amico, ancora professore associato all'inizio dei suoi cinquanta anni (come tutti gli altri), il sistema puniva con meno risorse gli abbandoni al primo anno. Soluzione: al primo anno non si fa praticamente niente, si comincia a fare sul serio al secondo, e se li seghiamo lì va bene a tutti (molto razionale, vero?). Ma c'era un problema: per gli stessi motivi, biologia, che tradizionalmente ricopriva anche il ruolo di refugium peccatorum della facoltà di scienze, onde evitare maree di iscritti desiderosi di intraprendere il percorso a più bassa energia offerto dalla facoltà (nonché i "rifugiati" provenienti dal secondo anno di altri corsi di laurea), e quindi il rischio di alto abbandono al primo anno, aveva messo il numero chiuso. Conseguenza, chi non passava il test di ingresso si buttava sul corso di laurea meno ostico rimasto a ingresso libero, cioè chimica. E buona parte di costoro non era in grado di superare l'asticella ormai rasoterra degli esami del primo anno a chimica, e abbandonava, provocando un malus per il dipartimento. Soluzione obbligata, numero chiuso a chimica. Roba da ridere, non fosse in realtà dannatamente tragica.

Qual'era il pregio dell'antico/vecchio ordinamento pre Gelmini e pre Berlinguer? La sua democraticità. A nessuno veniva negato l'accesso. Poi stava a lui riuscire a percorrere la strada. E guarda caso era lo stesso sistema che provveddeva adeguatamente alle borse del Diritto allo Studio per studenti meritevoli provenienti da famiglie economicamente disagiate - risorse largamente evaporate negli anni più recenti. In breve, si offrivano pari opportunità di istruzione universitaria.

Il numero chiuso invece è meritocratico solo in apparenza. Scarica l'onere sulla scuola (di cui tutti conosciamo il declino) e sulle famiglie. E' il sistema all'ammericana, dove ricordiamo che l'università pubblica (come la sanità pubblica) è serie C.

Personalmente resto legato alla vecchia concezione delle socialdemocrazie europee (quella che oggi alcuni stigmatizzano come "comunismo"), del tutto opposta alle concezioni dell'attuale PSE. E sarebbe il caso che si spieghi ai giovani cos'è che la politica degli ultimi vent'anni ha scippato loro.

Ah, inoltre da noi il 3+2, che amplificava la tendenza Gelmini verso la trasformazione dell'università in esamificio/diplomificio, alla fine non è riuscito neanche a fare da booster al numero dei laureati: ancora penultimi in Europa (https://www.ilmessaggero.it/primopiano/scuola_e_universita/eurostat_italia_penultima_laureati_ue-3656318.html). Ma, paradossalmente, ancora esportatori netti di laureati (per dire che nonostante la devastazione riusciamo comunque a sfornare laureati di qualità superiore a quella media internazionale).

I dati dello scorso autunno certificavano il fallimento della riforma.

https://www.roars.it/online/universita-fallita-la-formula-32/

Andando indietro nel tempo di un cinque-dieci anni invece mi ricordo che avevamo un problema di allineamento delle qualifiche. La nostra vecchia laurea era più di un master anglosassone, da un punto di vista del contenuto formativo, e meno di un PhD. Veniva allineata ai master, al ribasso, e i nostri dottorati venivano allineati ai PhD (pure se, secondo molti, erano qualcosa di più). All'incirca in quel periodo cominciai a udire i germi di quel paradigma che avrebbe portato alla situazione attuale. Un rettore in un'intervista ad un quotidiano ebbe a dichiarare che una buona università si fa con buoni studenti. Cosa che a me pareva aberrante (da studente): mi pareva scontato che una buona università si facesse con una buona didattica.

Il modello dei tempi, quello dell'ordinamento antico, non prevedeva numero chiuso. Nessuna barriera all'ingresso e selezione basata sugli esami: quindi alto numero di abbandoni e di fuori corso.

Al primo anno dove avevo iniziato il mio percorso universitario eravamo una quarantina di matricole. All'inizio del secondo anno eravamo una ventina. A seguire i corsi del quinto anno eravamo in dieci.

Venticinque anni dopo, tornando brevemente nel luogo di origine, la situazione era cambiata. L'infame combinato disposto di riforma Gelmini e 3+2 aveva provocato conseguenze per me inimmaginabili. Come mi spiegò un vecchio amico, ancora professore associato all'inizio dei suoi cinquanta anni (come tutti gli altri), il sistema puniva con meno risorse gli abbandoni al primo anno. Soluzione: al primo anno non si fa praticamente niente, si comincia a fare sul serio al secondo, e se li seghiamo lì va bene a tutti (molto razionale, vero?). Ma c'era un problema: per gli stessi motivi, biologia, che tradizionalmente ricopriva anche il ruolo di refugium peccatorum della facoltà di scienze, onde evitare maree di iscritti desiderosi di intraprendere il percorso a più bassa energia offerto dalla facoltà (nonché i "rifugiati" provenienti dal secondo anno di altri corsi di laurea), e quindi il rischio di alto abbandono al primo anno, aveva messo il numero chiuso. Conseguenza, chi non passava il test di ingresso si buttava sul corso di laurea meno ostico rimasto a ingresso libero, cioè chimica. E buona parte di costoro non era in grado di superare l'asticella ormai rasoterra degli esami del primo anno a chimica, e abbandonava, provocando un malus per il dipartimento. Soluzione obbligata, numero chiuso a chimica. Roba da ridere, non fosse in realtà dannatamente tragica.

Qual'era il pregio dell'antico/vecchio ordinamento pre Gelmini e pre Berlinguer? La sua democraticità. A nessuno veniva negato l'accesso. Poi stava a lui riuscire a percorrere la strada. E guarda caso era lo stesso sistema che provveddeva adeguatamente alle borse del Diritto allo Studio per studenti meritevoli provenienti da famiglie economicamente disagiate - risorse largamente evaporate negli anni più recenti. In breve, si offrivano pari opportunità di istruzione universitaria.

Il numero chiuso invece è meritocratico solo in apparenza. Scarica l'onere sulla scuola (di cui tutti conosciamo il declino) e sulle famiglie. E' il sistema all'ammericana, dove ricordiamo che l'università pubblica (come la sanità pubblica) è serie C.

Personalmente resto legato alla vecchia concezione delle socialdemocrazie europee (quella che oggi alcuni stigmatizzano come "comunismo"), del tutto opposta alle concezioni dell'attuale PSE. E sarebbe il caso che si spieghi ai giovani cos'è che la politica degli ultimi vent'anni ha scippato loro.

Ah, inoltre da noi il 3+2, che amplificava la tendenza Gelmini verso la trasformazione dell'università in esamificio/diplomificio, alla fine non è riuscito neanche a fare da booster al numero dei laureati: ancora penultimi in Europa (https://www.ilmessaggero.it/primopiano/scuola_e_universita/eurostat_italia_penultima_laureati_ue-3656318.html). Ma, paradossalmente, ancora esportatori netti di laureati (per dire che nonostante la devastazione riusciamo comunque a sfornare laureati di qualità superiore a quella media internazionale).

I dati dello scorso autunno certificavano il fallimento della riforma.

https://www.roars.it/online/universita-fallita-la-formula-32/

mercoledì 18 luglio 2018

INDUSTRIA, INQUINAMENTO: L'EIETTORE WIEGAND

In più d'uno ha commentato il post sull'incidente di Seveso del 1976 dicendo "già l'azienda di base emetteva inquinanti in piccole quantità". La cosa non dovrebbe stupire. Uno dei problemi più classici della chimica industriale, specialmente se si parla di chimica organica e chimica farmaceutica, è la gestione delle emissioni. E principalmente le emissioni sono vapori di solventi e simili, altresì noti come VOC (Volatile Organics Compunds) - come visto nel post di ieri sullo stabilimento Sanofi Chimie nei PIrenei. Le emissioni provengono in primis da operazioni di distillazione o riflusso, e in particolare dalle distillazioni sotto vuoto.

Il razionale è abbastanza semplice: quando distilli i vapori vengono condensati in scambiatori di calore e il liquido condensato viene raccolto a parte (o riconvogliato nel reattore, in caso di riflusso). Ma quale sarà la pressione parziale dei vapori in uscita dallo scambiatore? Al minimo sarà uguale alla tensione di vapore di quel componente (o di quella miscela di componenti) alla temperatura del liquido refrigerante che scorre dentro gli elementi dello scambiatore. E di solito il liquido refrigerante è acqua fredda (10°C, convenzionalmente). Ma un composto organico volatile è così chiamato perché già a temperatura ambiente la sua tensione di vapore è consistente. Quindi già distillando a pressione atmosferica una minima frazione del solvente se ne va all'aria (o meglio, ai sistemi di abbattimento o di ossidazione catatilica) ogniqualvolta si crei per un qualsiasi motivo una differenza positiva di pressione tra scambiatore e sfiato.

Quando si distilla a pressione ridotta (sotto vuoto) le cose peggiorano sensibilmente, perché c'è il flusso in uscita provocato dalla pompa da vuoto.

Dal post sull'incidente di Seveso avrete capito che l'industria chimica andava a vapore (tuttora, in buona parte). Con il vapore si scaldava, e con il vapore si faceva il vuoto, usando eiettori a vapore.

I tubi di venturi sono stati largamente usati nei laboratori per ottenere basso-medio vuoto (le cosiddette pompe da vuoto ad acqua, in vetro o plastica, che funzionano attaccate ad un rubinetto). Sono basati sull'effetto Venturi (https://it.wikipedia.org/wiki/Effetto_Venturi). In teoria qualsiasi fluido può essere usato con un tubo di venturi per ottenere il vuoto. In pratica oltre l'acqua in laboratorio è stata proposta l'aria compressa (prodotti di scarsa fortuna, nei laboratori di chimica, perché di solito tra i servizi disponibili non c'è aria compressa a media pressione). E in impianti industriali è stato usato il vapore sovrasaturo (surriscaldato).

Se guardate l'illustrazione, che raffigura un eiettore Wiegand, A è l'ingresso del vapore, e B è collegato al sistema dove si vuole ottenere la pressione ridotta. Ora dovrebbe essere abbastanza evidente che assieme al vapore da C esce tutto quanto viene evacuato da B (cioè vapori non condensati provenienti da sistema di reazione).

Negli anni ruggenti i Wiegand venivano installati sul tetto dei reparti. E ovviamente tutto quello che usciva da C andava nell'aria.

La regolazione normativa delle emissioni a partire dagli anni 80 ha fatto gradualmente sparire gli eiettori Wiegand installati per questo uso.

martedì 10 luglio 2018

L'INCIDENTE DI SEVESO (E IL CONTESTO)

La chimica organica industriale degli anni 60 e 70 in Italia non era precisamente "state of the art process chemistry".

C'era una questione di cultura industriale: relativamente pochi laureati, più periti, tanti operai specializzati. Il know how necessario era spesso acquisito tramite consulenze universitarie, ma ho sentito raccontare di contesti in cui a fare il Direttore Tecnico c'era un ragionere cresciuto dentro l'azienda (ancora nei primi anni novanta il responsabile dell'impianto pilota di una chimica farmaceutica non delle meno note era un perito, che sosteneva che i laureati non servivano, in quanto aveva visto un buon numero di chimici organici arrivare in azienda e non riuscire a portare sull'impianto neanche un prodotto nell'arco di un anno - capirai, un chimico puro di indirizzo organico non aveva la minima idea di cosa potesse essere un impianto, figurati portarci sopra una sintesi da 0 appena uscito dall'università).

Di storie balorde degli "anni ruggenti" ne ho sentite davvero tante, ma l'incidente di Seveso del 1976 ha avuto il dubbio onore di diventare un caso di scuola di importanza storica e mondiale nel campo "sicurezza degli impianti chimici".

Il 10 luglio 1976 circa alle 12.30 si verificò nello stabilimento ICMESA l'incidente che provocò il rilascio nell'atmosfera di 1 kg di TCDD (tetraclorodibenzodiossina) (qualcuno ha scritto 13 kg, che sembra decisamente eccessivo). L'effetto acuto fu costituito da 200 casi di cloracne. Ma peggio fu il risultato a lungo termine, con un aumento di casi di mieloma multiplo e leucemia mieloide.

Perché successe? La lavorazione, da quel che ho potuto ricostruire, avveniva in un semitubo di acciaio da 500 l (quindi un reattore piccolo). Ovvero un reattore con una serpentina di semitubo saldata a spirale lungo le pareti, in cui si fa passare il mezzo di scambio termico. La reazione che vi veniva fatta era la sintesi del triclorofenolo da tetraclorobenzene e soda, in glicole etilenico, con il reattore riempito per quattro quinti. La miscela bolliva a 160°C, e la temperatura interna di reazione erano 158°C. Data l'alta temperatura, per scaldare serviva vapore ad alta pressione (o olio diatermico, ma evidentemente non era un servizio disponibile sull'impianto). E presero quello esaurito dalla turbina della centrale elettrica del sito, che usciva a 12 atm (190°C). Ma senza mettere un controllo su temperatura o pressione del vapore in ingresso alla serpentinadel reattore.

Primo punto: venne cominciata una produzione di venerdì, quando il venerdì sera tutto l'impianto doveva essere fermato per il week end. Mentre tutte le altre macchine venivano vuotate e fermate, quel 500 litri continuava a lavorare, ritrovandosi per un breve tempo ad essere scaldato da vapore più caldo del solito (circa 300°C).

Secondo punto: non so se fossero le direttive che imponevano comunque di lasciare spente tutte le macchine, non so se fu l'operatore a farlo senza pensarci. Fatto sta che l'operatore non raffreddò, chiuse il vapore (quindi smise di riscaldare, nella sua testa), fermò l'agitazione (questa è una cosa che a voi non dirà niente, ma quando ho visto gente fermare l'agitazione a reattori pieni ho sempre dato in escandescenze - un reattore deve avere buono scambio termico e buona agitazione, in primo luogo, e un motivo c'è).

Lo spegnimento dell'agitazione fu la prima causa. La parete del reattore sopra il livello del liquido era rimasta sopra i 250°C. In assenza di agitazione cominciò a surriscaldare la parte superiore della massa liquida, facendo partire localmente una reazione parassita inizialmente lenta ma esotermica. Sette ore dopo l'esotermia aveva progressivamente riscaldato la massa reagente, arrivando a 250°C di temperatura interna, innescando una runaway (prima o poi spiegherò la cosa), con forte e veloce aumento della pressione interna. Il reattore era dotato di un disco di scoppio, ovvero di un dispositivo tarato per il rilascio di pressione oltre un certo limite. E questa era una cosa buona. Ma l'uscita del disco di scoppio non era convogliata a nessun sistema di contenimento (classicamente una vasca). Il disco di scoppio era en plein air. E nell'aria rilascio i 400 kg di massa reagente, liquida,spinta dalla pressione dei vapori, comprensiva del famoso chilo di TCDD.

Quindi, riepilogando, nessun controllo su pressione o temperatura del vapore, fermo dell'agitazione, disco di scoppio all'aria: la ricetta di un disastro storico.

(Nell'immagine un disco di scoppio)

C'era una questione di cultura industriale: relativamente pochi laureati, più periti, tanti operai specializzati. Il know how necessario era spesso acquisito tramite consulenze universitarie, ma ho sentito raccontare di contesti in cui a fare il Direttore Tecnico c'era un ragionere cresciuto dentro l'azienda (ancora nei primi anni novanta il responsabile dell'impianto pilota di una chimica farmaceutica non delle meno note era un perito, che sosteneva che i laureati non servivano, in quanto aveva visto un buon numero di chimici organici arrivare in azienda e non riuscire a portare sull'impianto neanche un prodotto nell'arco di un anno - capirai, un chimico puro di indirizzo organico non aveva la minima idea di cosa potesse essere un impianto, figurati portarci sopra una sintesi da 0 appena uscito dall'università).

Di storie balorde degli "anni ruggenti" ne ho sentite davvero tante, ma l'incidente di Seveso del 1976 ha avuto il dubbio onore di diventare un caso di scuola di importanza storica e mondiale nel campo "sicurezza degli impianti chimici".

Il 10 luglio 1976 circa alle 12.30 si verificò nello stabilimento ICMESA l'incidente che provocò il rilascio nell'atmosfera di 1 kg di TCDD (tetraclorodibenzodiossina) (qualcuno ha scritto 13 kg, che sembra decisamente eccessivo). L'effetto acuto fu costituito da 200 casi di cloracne. Ma peggio fu il risultato a lungo termine, con un aumento di casi di mieloma multiplo e leucemia mieloide.

Perché successe? La lavorazione, da quel che ho potuto ricostruire, avveniva in un semitubo di acciaio da 500 l (quindi un reattore piccolo). Ovvero un reattore con una serpentina di semitubo saldata a spirale lungo le pareti, in cui si fa passare il mezzo di scambio termico. La reazione che vi veniva fatta era la sintesi del triclorofenolo da tetraclorobenzene e soda, in glicole etilenico, con il reattore riempito per quattro quinti. La miscela bolliva a 160°C, e la temperatura interna di reazione erano 158°C. Data l'alta temperatura, per scaldare serviva vapore ad alta pressione (o olio diatermico, ma evidentemente non era un servizio disponibile sull'impianto). E presero quello esaurito dalla turbina della centrale elettrica del sito, che usciva a 12 atm (190°C). Ma senza mettere un controllo su temperatura o pressione del vapore in ingresso alla serpentinadel reattore.

Primo punto: venne cominciata una produzione di venerdì, quando il venerdì sera tutto l'impianto doveva essere fermato per il week end. Mentre tutte le altre macchine venivano vuotate e fermate, quel 500 litri continuava a lavorare, ritrovandosi per un breve tempo ad essere scaldato da vapore più caldo del solito (circa 300°C).

Secondo punto: non so se fossero le direttive che imponevano comunque di lasciare spente tutte le macchine, non so se fu l'operatore a farlo senza pensarci. Fatto sta che l'operatore non raffreddò, chiuse il vapore (quindi smise di riscaldare, nella sua testa), fermò l'agitazione (questa è una cosa che a voi non dirà niente, ma quando ho visto gente fermare l'agitazione a reattori pieni ho sempre dato in escandescenze - un reattore deve avere buono scambio termico e buona agitazione, in primo luogo, e un motivo c'è).

Lo spegnimento dell'agitazione fu la prima causa. La parete del reattore sopra il livello del liquido era rimasta sopra i 250°C. In assenza di agitazione cominciò a surriscaldare la parte superiore della massa liquida, facendo partire localmente una reazione parassita inizialmente lenta ma esotermica. Sette ore dopo l'esotermia aveva progressivamente riscaldato la massa reagente, arrivando a 250°C di temperatura interna, innescando una runaway (prima o poi spiegherò la cosa), con forte e veloce aumento della pressione interna. Il reattore era dotato di un disco di scoppio, ovvero di un dispositivo tarato per il rilascio di pressione oltre un certo limite. E questa era una cosa buona. Ma l'uscita del disco di scoppio non era convogliata a nessun sistema di contenimento (classicamente una vasca). Il disco di scoppio era en plein air. E nell'aria rilascio i 400 kg di massa reagente, liquida,spinta dalla pressione dei vapori, comprensiva del famoso chilo di TCDD.

Quindi, riepilogando, nessun controllo su pressione o temperatura del vapore, fermo dell'agitazione, disco di scoppio all'aria: la ricetta di un disastro storico.

(Nell'immagine un disco di scoppio)

CI SONO COSE CHE VANNO SPIEGATE... (SUSCETTIBILI AL MORBILLO IN ITALIA) - I

(...poi anche se le spieghi alle volte non c'è proprio verso, in nessun modo)

Su twitter il genio di turno è arrivato a dirmi che il calo coperture pre 2015 è colpa dei populisti, e che quindi i (quasi) 7000 casi di morbillo da inizio 17 all'ultimo 28 giugno sono colpa dei populisti, e gli inglesi fanno bene ad avercela con i populisti perché è colpa loro.

E già così siamo sul surreale andante. Ma la cosa ha preso una piega grottesca quando si è arrivati a parlare di serbatoio di suscettibili al morbillo in Italia. Eppure a me sembrava un qualcosa di banale, terra terra. Ma non c'è stato verso, e May e Anderson si sono beccati dei "fuffari" per il tramite della mia indegna persona.

Comunque visto che le cose forse non sono così semplici, proviamo a dettagliare.

La teoria generale della dinamica delle malattie infettive prevenibili da vaccino prevede un set di equazioni differenziali, e una riguarda i suscettibili (Anderson, May, Nature 318(6044):323-9 · November 1985) :

dove a è l'età, t il tempo, M la popolazione infantile, v il tasso di vaccinazione, λ la velocità di propagazione dell'infezione, μ la mortalità. La vaccinazione viene ipotizzata con efficacia permanente e del 100%.

Possiamo riscrivere l'equazione così

Senza farsi spaventare, vediamo di spiegare questa equazione.

dM(a,t) è la variazione della popolazione infantile, ovvero fondamentalmente la natalità.

I contributi negativi sono costituiti dal tasso di vaccinazione v(a,t)X, dalla morbilità λ(a,t)X, dalla mortalità dei suscettibili μ(a)X.

Possiamo così semplificare l'equazione (n.b. ovviamente non è un'integrazione dell'equazione in senso stretto):

L'incremento di suscettibili ΔX in un periodo di tempo è uguale ai nati in quel periodo di tempo meno i suscettibili vaccinati in quel periodo di tempo, meno i suscettibili ammalatisi in quel periodo di tempo (ovvero i casi di quell'infezione registrati in quel periodo di tempo), meno i suscettibili deceduti in quel periodo di tempo. Il contributo alla popolazione dei suscettibili nell'anno i lo possiamo quindi scrivere, passando a dati rilevati in quell'anno

Dove vi sono le vaccinazioni per l'anno i e λi i casi di malattia per l'anno i. Notare che μ(a)X l'ho lasciato sotto forma di funzione, perché nessuno registra le morti totali di suscettibili alla malattia y, al massimo quelli che per tale malattia sono deceduti. μ(a) è senz'altro ricavabile, ma X, popolazione totale dei suscettibili, resta ignota.

Ma per determinate finestre temporali una stima sensata di μ(a)X è fattibile. Per esempio, nel caso del morbillo, in un periodo a circolazione dell'infezione abbastanza alta preceduto da un lungo periodo a circolazione altissima, e con un programma di immunizzazione che prima decolla lentamente e poi viene sospeso, con mortalità infantile bassa (anni 80, per essere chiari), in prima battuta per una stima approssimata possiamo considerare μ(a)X sufficientemente piccola da poter essere trascurata (ovvero ritenere che i decessi siano costituiti quasi esclusivamente da soggetti immuni)

Al che per gli anni 80 l'accumulo di suscettibili al morbillo può essere scritto così:

che tradotto vuol dire: accumulo di suscettibili nel decennio uguale a nascite meno vaccinazioni meno casi di morbillo. E ripeto, per le cervici più coriacee, che il conto vale nell'ipotesi di vaccinazione di efficacia permanente e del 100% e mortalità dei suscettibili trascurabile.

giovedì 5 luglio 2018

UN CLASSICO (DELLA PSEUDOMEDICINA?)

Et mulier, quae erat in profluvio sanguinis annis duodecim et fuerat multa perpessa a compluribus medicis et erogaverat omnia sua nec quidquam profecerat, sed magis deterius habebat, cum audisset de Iesu, venit in turba retro et tetigit vestimentum eius; dicebat enim: “ Si vel vestimenta eius tetigero, salva ero ”.

Et confestim siccatus est fons sanguinis eius, et sensit corpore quod sanata esset a plaga.

Et statim Iesus cognoscens in semetipso virtutem, quae exierat de eo, conversus ad turbam aiebat: “ Quis tetigit vestimenta mea? ”.

Et dicebant ei discipuli sui: “ Vides turbam comprimentem te et dicis: “Quis me tetigit?” ”.

Et circumspiciebat videre eam, quae hoc fecerat.

Mulier autem timens et tremens, sciens quod factum esset in se, venit et procidit ante eum et dixit ei omnem veritatem.

Ille autem dixit ei: “ Filia, fides tua te salvam fecit. Vade in pace et esto sana a plaga tua ”.

Il soggetto, un cittadino della Galilea, privo di titoli di studio, essendo stato provato il suo abusivo esercizio della professione medica, di lì a poco veniva condannato a morte con immediata esecuzione della sentenza.

(ovvero, il tema è classico e archetipico; e in troppi lo liquidano come se si trattasse di banali, insignificanti idiozie)

domenica 1 luglio 2018

VACCINI: I GRANDI CLASSICI 3 - ALLUMINIO

Nota di metodo: i dati della miniserie "Grandi Classici" vengono da toxnet, database del National Institute of Health (NIH). Quindi il primo titolato o non titolato che arrivasse a commentare sotto questi post con le parole "cherry picking" sarà spernacchiato.

Alluminio, ovvero la nota dolente. Se sul Thimerosal ormai il consenso è diffuso e può essere eliminato dalle formulazioni, se la formaldeide residua entro i limiti dichiarati non è un problema, con l'alluminio si arriva al punto ineludibile. Anche certi vaccine advocates lo usano come argomento: i vaccini polivalenti per loro sono meglio dei monovalenti perché in questo modo si limita il dosaggio di alluminio. Sull'alluminio quindi il nervosismo è alto, la tensione costante, e la polemica ha dato il peggio di sé, producendo una quantità imponente di ciarpame e idiozie.

Non parleremo qua di Al(0), ovvero alluminio metallico, né di allume di potassio (a quelli che "con l'alluminio in genere non c'è problema" farei acquisire familiarità con AlCl3, Litio Alluminio Idruro, DIBAL-H e soprattutto con il composto più amato, si fa per dire, nella sintesi chimica, il Trimetilalluminio).

Qua parleremo di Alluminio Idrossido, Al(OH)3, ovvero il più diffuso adiuvante usato nella formulazione di vaccini, e quello di cui non si può fare a meno.

E sappiamo bene che, assunto per via orale, ha una tossicità di fatto nulla (ma ci sono casi interazioni con assunzione di alcuni farmaci).

Partiamo ancora una volta da LD50, che ricordo è il dosaggio che provoca la morte nella metà delle cavie usate per il test di tossicologia acuta.

LD50 nel ratto per os è superiore a 5g/Kg. Il che vuol dire che a far mangiare a un ratto idrossido di alluminio è più facile ucciderlo per indigestione o blocco intestinale che per effetti tossici della sostanza.

E la cosa non dovrebbe stupire, date le migliaia di tonnellate di Maalox che gli esseri umani hanno consumato negli ultimi 50 anni.

Quindi non c'è problema? No, non c'è problema a mangiarlo, l'alluminio idrossido. Perché somministrato per iniezione intraperitoneale LD50 nel ratto è 1.1g/Kg. Tossicità sempre molto bassa, ma non paragonabile a quella dell'assunzione orale.

E poi parliamo di LD50, cioè di effetti letali. E quanto agli effetti non letali?

Qui le cose si complicano un poco, e forse qua stanno i motivi del nervosismo di molti.

[Gherardi RK et al; Brain 124 (Pt 9): 1821-31 (2001)]: Miofascite Macrofagica (conseguenze diffusi dolori muscolari e articolari, affaticamento): 40 casi esaminati, in tutti rilevate inclusioni citoplasmatiche di idrossido di alluminio, tutti i soggetti erano stati sottoposti a una o più vaccinazioni e l'insorgenza della malattia in media si è verificata 11 mesi dopo il vaccino.

[Gherardi RK; Rev Neurol (Paris) 159 (2): 162-4 (2003)] Review riguardo la MMF.

(Gherardi è un caso curioso: il paper del 2001 è un lavoro ben fatto che non mi risulta sia mai stato confutato o simili. In tempi più recenti invece si è messo a fare review insalata mista e meta review di dati vetusti di spessore assai più esiguo)

Pubblicazioni originate largamente dal campo degli studi sulla Sindrome della Guerra del Golfo.

E considerato che i soggetti, oltre che a una massicia serie di vaccinazioni, sono stati tutti esposti in proporzioni variabili ad una serie di altri fattori (da particolato di uranio impoverito a tracce di gas nervini), si tratta di studi significativi ma non estrapolabili a condizioni "normali". In più, per vedere un qualche genere di correlazione, andrebbe capito quanto Al(OH)3 fu somministrato nei singoli individui. Altro punto: dal 1990 ad oggi le formulazioni dei vaccini sono cambiate consistentemente, ricordo lo snodo 99-2001 per l'uso di thymerosal.

Ci sono tre articoli su effetti neurotossici in modelli animali, tra cui questo

[Shaw CA, Petrik MS.; J Inorg Biochem. 103 (11): 1555-62 (2009)]. Ma occorre notare che il dosaggio di Al(OH)3 in questi casi è estremamente alto (anche nei dosaggi etichettati "bassi"), oppure si tratta di iniezioni intracraniche. Di scarsa estendibilità per quel che riguarda dosaggi molto bassi nell'uomo.

Shaw è ormai un marchio e una garanzia. Dopo anni di risultati vagamente indiziari, statisticamente non significativi e non conclusivi, ha provato ha ottenere di più ed è stato beccato: falsificazione dei dati, articolo ritirato (https://retractionwatch.com/2017/10/09/journal-retract-paper-called-anti-vaccine-pseudoscience/).

Ovviamente c'è chi, confondendo le carte, fa apparire le conoscenze attuali conclusive, eccome. Prendiamo il fronte vaccinista.

Ormai avrete capito che mediamente a un medico è rimasta addosso poca farmacologia, e quasi niente di chimica e tossicologia.

Un caso di scuola in questo senso è la Dr.ssa Leila Bianchi, pediatra del Meyer di Firenze citata da Iovaccino:

"Se il mercurio non è praticamente più utilizzato - ha spiegato Bianchi - l'alluminio, usato come adiuvante, è difficilmente eliminabile ma è presente in quantità minime: quello assunto con un vaccino è al massimo 4 mg, mentre quello ingerito in un giorno con il latte materno ammonta a 10 mg, che salgono a 40 se il bambino è alimentato con i latti formula e a 120 con il latte di soia. In quanto alle reazioni allergiche, il rischio di svilupparne una con un vaccino è inferiore a quello di diventare presidente degli Stati Uniti"

Che assumere alluminio per os non costituisce un problema lo abbiamo visto, ma abbiamo anche ribadito quel che dovrebbe essere scontato: la modalità di somministrazione cambia l'effetto della sostanza, iniettare e dar da mangiare sono cose assai diverse...

(Mi rendo conto che per la sua onnipresenza nelle formulazioni l'alluminio è un bersaglio attraente per chi contesta i vaccini, ma per inconclusivo intendo proprio che non si può concludere niente in un senso o nell'altro, per i dosaggi attualmente presenti, sulla base dei dati disponibili. Dove andare a cercare? A costo di annoiare chi legge, nei dati di farmacovigilanza).

https://toxnet.nlm.nih.gov/cgi-bin/sis/search/a?dbs+hsdb:@term+@DOCNO+575

Iscriviti a:

Commenti (Atom)

CHI SONO? UNO COME TANTI (O POCHI)

Con una laurea in Chimica Industriale (ordinamento ANTICO, come sottolineava un mio collega più giovane) mi sono ritrovato a lavorare in ...